Cara memasang kafka pada rhel 8

- 2345

- 665

- Clarence Tromp

Apache Kafka adalah platform streaming yang diedarkan. Dengan set API yang kaya (Antara Muka Pengaturcaraan Aplikasi), kita boleh menyambung kebanyakan apa -apa ke Kafka sebagai sumber data, dan di hujung yang lain, kami dapat menubuhkan sejumlah besar pengguna yang akan menerima stim rekod untuk diproses. Kafka sangat berskala, dan menyimpan aliran data dengan cara yang boleh dipercayai dan bersalah. Dari perspektif sambungan, Kafka dapat berfungsi sebagai jambatan antara banyak sistem heterogen, yang seterusnya dapat bergantung pada keupayaannya untuk memindahkan dan meneruskan data yang disediakan.

Dalam tutorial ini, kami akan memasang Apache Kafka di Red Hat Enterprise Linux 8, Buat sistemd fail unit untuk memudahkan pengurusan, dan menguji fungsi dengan alat baris arahan yang dihantar.

Dalam tutorial ini anda akan belajar:

- Cara memasang Apache Kafka

- Cara Membuat Perkhidmatan Sistem untuk Kafka dan Zookeeper

- Cara Menguji Kafka dengan Pelanggan Talian Perintah

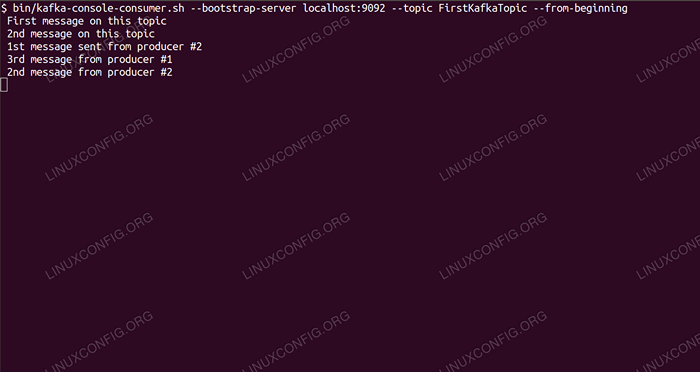

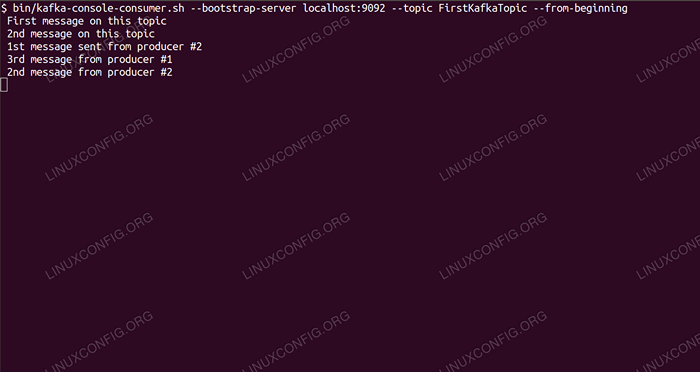

Memakan mesej mengenai topik Kafka dari baris arahan.

Memakan mesej mengenai topik Kafka dari baris arahan. Keperluan perisian dan konvensyen yang digunakan

| Kategori | Keperluan, konvensyen atau versi perisian yang digunakan |

|---|---|

| Sistem | Red Hat Enterprise Linux 8 |

| Perisian | Apache Kafka 2.11 |

| Yang lain | Akses istimewa ke sistem linux anda sebagai akar atau melalui sudo perintah. |

| Konvensyen | # - Memerlukan arahan Linux yang diberikan untuk dilaksanakan dengan keistimewaan akar sama ada secara langsung sebagai pengguna root atau dengan menggunakan sudo perintah$ - Memerlukan arahan Linux yang diberikan sebagai pengguna yang tidak layak |

Cara Memasang Kafka Pada Redhat 8 Langkah demi Langkah Arahan

Apache Kafka ditulis di Java, jadi yang kita perlukan adalah OpenJDK 8 dipasang untuk meneruskan pemasangan. Kafka bergantung pada Apache Zookeeper, perkhidmatan koordinasi yang diedarkan, yang juga ditulis di Jawa, dan dihantar dengan pakej yang akan kami muat turun. Semasa memasang perkhidmatan HA (ketersediaan tinggi) ke nod tunggal membunuh tujuan mereka, kami akan memasang dan menjalankan Zookeeper untuk Kafka.

- Untuk memuat turun Kafka dari cermin terdekat, kita perlu berunding dengan laman muat turun rasmi. Kita boleh menyalin URL

.tar.Gzfail dari sana. Kami akan menggunakanwget, Dan URL disisipkan untuk memuat turun pakej ke mesin sasaran:# wget https: // www-eu.Apache.org/dist/kafka/2.1.0/Kafka_2.11-2.1.0.tgz -o /opt /kafka_2.11-2.1.0.TGZ

- Kami memasuki

/MemilihDirektori, dan ekstrak arkib:# cd /opt # tar -xvf kafka_2.11-2.1.0.TGZ

Dan buat symlink yang dipanggil

/opt/kafkayang menunjukkan kepada yang dibuat sekarang/opt/kafka_2_11-2.1.0direktori untuk menjadikan kehidupan kita lebih mudah.ln -s /opt /kafka_2.11-2.1.0 /opt /kafka

- Kami mencipta pengguna yang tidak istimewa yang akan menjalankan kedua-duanya

penjaga zoodanKafkaperkhidmatan.# UserAdd Kafka

- Dan tetapkan pengguna baru sebagai pemilik seluruh direktori yang kami ekstrak, secara rekursif:

# chown -r kafka: kafka /opt /kafka*

- Kami membuat fail unit

/etc/Systemd/System/Zookeeper.perkhidmatandengan kandungan berikut:

Salinan[Unit] Description = Zookeeper selepas = syslog.rangkaian sasaran.sasaran [perkhidmatan] jenis = pengguna mudah = Kafka kumpulan = kafka execstart =/opt/kafka/bin/zookeeper-start.sh/opt/kafka/config/zookeeper.sifat execstop =/opt/kafka/bin/zookeeper-server-stop.SH [Pasang] Wanteby = Multi-User.sasaranPerhatikan bahawa kita tidak perlu menulis nombor versi tiga kali kerana symlink yang kita buat. Sama berlaku untuk fail unit seterusnya untuk kafka,

/etc/Systemd/System/Kafka.perkhidmatan, yang mengandungi baris konfigurasi berikut:

Salinan[Unit] Keterangan = Apache Kafka Memerlukan = Zookeeper.perkhidmatan selepas = zookeeper.Perkhidmatan [Service] Type = Simple User = Kafka Group = Kafka Execstart =/Opt/Kafka/Bin/Kafka-Server-Start.sh/opt/kafka/config/pelayan.sifat execstop =/opt/kafka/bin/kafka-server-stop.SH [Pasang] Wanteby = Multi-User.sasaran - Kita perlu memuatkan semula

sistemdUntuk membacanya membaca fail unit baru:

# Systemctl Daemon-Reload

- Sekarang kita boleh memulakan perkhidmatan baru kita (mengikut urutan ini):

# Systemctl Mula Zookeeper # Systemctl Mula Kafka

Sekiranya semuanya berjalan lancar,

sistemdSekiranya melaporkan keadaan berjalan pada status kedua -dua perkhidmatan, sama seperti output di bawah:# Systemctl Status Zookeeper.Perkhidmatan Zookeeper.Perkhidmatan - Zookeeper dimuatkan: dimuatkan (/etc/systemd/system/zookeeper.perkhidmatan; dilumpuhkan; Pratetap Vendor: Dilumpuhkan) Aktif: Aktif (Berlari) Sejak THU 2019-01-10 20:44:37 CET; 6s Ago PID Utama: 11628 (Java) Tugas: 23 (Had: 12544) Memori: 57.0m cgroup: /sistem.Slice/Zookeeper.Perkhidmatan 11628 Java -xmx512m -xms512m -server [...] # Systemctl Status Kafka.Perkhidmatan Kafka.Perkhidmatan - Apache Kafka dimuatkan: dimuatkan (/etc/systemd/system/kafka.perkhidmatan; dilumpuhkan; Pratetap Vendor: Dilumpuhkan) Aktif: Aktif (Berlari) Sejak THU 2019-01-10 20:45:11 CET; 11s Ago PID Utama: 11949 (Java) Tugas: 64 (Had: 12544) Memori: 322.2m cgroup: /sistem.Slice/Kafka.Perkhidmatan 11949 Java -xmx1g -xms1g -server [...]

- Secara pilihan kita boleh mengaktifkan permulaan automatik pada boot untuk kedua -dua perkhidmatan:

# Systemctl Dayakan Zookeeper.Perkhidmatan # Systemctl Dayakan Kafka.perkhidmatan

- Untuk menguji fungsi, kami akan menyambung ke Kafka dengan satu pengeluar dan satu pelanggan pengguna. Mesej yang disediakan oleh pengeluar sepatutnya muncul di konsol pengguna. Tetapi sebelum ini kita memerlukan medium kedua -dua mesej pertukaran ini. Kami membuat saluran data baru yang dipanggil

topikdalam istilah Kafka, di mana pembekal akan menerbitkan, dan di mana pengguna akan melanggan. Kami akan memanggil topikFirstKafkatopic. Kami akan menggunakanKafkapengguna untuk membuat topik:$/opt/kafka/bin/kafka-topik.SH --Create-Zookeeper Localhost: 2181-Factor-Factor 1-Partisi 1-Topic FirstKafkatopic

- Kami memulakan pelanggan pengguna dari baris arahan yang akan melanggan topik (pada masa ini kosong) yang dibuat pada langkah sebelumnya:

$/opt/kafka/bin/kafka-console-consumer.SH-Bootstrap-Server Localhost: 9092 --Topik FirstKafkatopic --Dari-Beginning

Kami meninggalkan konsol dan pelanggan yang berjalan di dalamnya terbuka. Konsol ini adalah di mana kami akan menerima mesej yang kami siarkan dengan pelanggan pengeluar.

- Di terminal lain, kami memulakan pelanggan pengeluar, dan menerbitkan beberapa mesej kepada topik yang kami buat. Kami boleh menanyakan Kafka untuk topik yang ada:

$/opt/kafka/bin/kafka-topik.sh -list --zookeeper localhost: 2181 firstkafkatopic

Dan sambungkan kepada pengguna yang dilanggan, kemudian hantar mesej:

$/opt/kafka/bin/kafka-console-producer.SH-Broker-List Localhost: 9092-Topic FirstKafkatopic> Mesej Baru Diterbitkan oleh Pengeluar dari Konsol #2

Di terminal pengguna, mesej itu sepatutnya muncul tidak lama lagi:

$/opt/kafka/bin/kafka-console-consumer.SH-Bootstrap-Server Localhost: 9092-Topic FirstKafkatopic-dari mesej baru yang dikembalikan oleh Producer dari Console #2

Sekiranya mesej itu muncul, ujian kami berjaya, dan pemasangan Kafka kami berfungsi seperti yang dimaksudkan. Ramai pelanggan dapat menyediakan dan menggunakan satu atau lebih topik rekod dengan cara yang sama, walaupun dengan persediaan nod tunggal yang kami buat dalam tutorial ini.

Tutorial Linux Berkaitan:

- Cara Menggunakan Rangkaian Berjalan dengan Libvirt dan KVM

- Perkara yang hendak dipasang di Ubuntu 20.04

- Cara Mencegah Pemeriksaan Sambungan RangkaianManager

- Cara memasang stim di ubuntu 22.04 Jammy Jellyfish Linux

- Pengenalan kepada Automasi, Alat dan Teknik Linux

- Cara Menggunakan Adb Android Debug Bridge untuk Mengurus Android Anda ..

- Menguasai Gelung Skrip Bash

- Gelung bersarang dalam skrip bash

- Ubuntu 20.04 WordPress dengan pemasangan Apache

- Cara Bekerja Dengan API Rest WooCommerce dengan Python