Cara Memasang Hadoop pada Rhel 8 / CentOS 8 Linux

- 4006

- 320

- Clay Weber

Apache Hadoop adalah kerangka sumber terbuka yang digunakan untuk penyimpanan yang diedarkan serta pemprosesan data besar mengenai kelompok komputer yang berjalan pada hardwares komoditi. Hadoop menyimpan data dalam sistem fail diedarkan Hadoop (HDFS) dan pemprosesan data ini dilakukan menggunakan MapReduce. Benang menyediakan API untuk meminta dan memperuntukkan sumber dalam kumpulan Hadoop.

Rangka kerja Apache Hadoop terdiri daripada modul berikut:

- Hadoop biasa

- Hadoop diedarkan Sistem Fail (HDFS)

- Benang

- MapReduce

Artikel ini menerangkan cara memasang Hadoop Versi 2 pada Rhel 8 atau CentOS 8. Kami akan memasang HDFS (Namenode dan Datanode), benang, MapReduce pada kluster nod tunggal dalam mod diedarkan pseudo yang diedarkan simulasi pada mesin tunggal. Setiap Daemon Hadoop seperti HDFS, Benang, MapReduce dll. akan dijalankan sebagai proses Java yang berasingan/individu.

Dalam tutorial ini anda akan belajar:

- Cara Menambah Pengguna untuk Persekitaran Hadoop

- Cara memasang dan mengkonfigurasi jdk oracle

- Cara Mengkonfigurasi SSH Tanpa Kata Laluan

- Cara Memasang Hadoop dan Konfigurasi Fail XML Berkaitan yang Diperlukan

- Cara Memulakan Kluster Hadoop

- Cara Mengakses UI Web Namenode dan ResourceManager

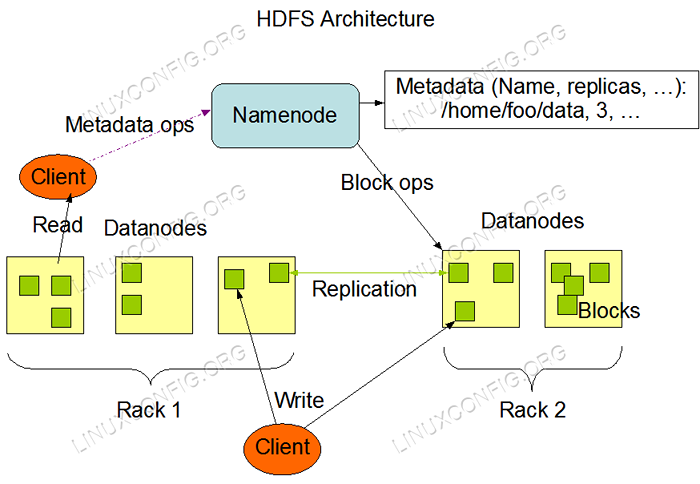

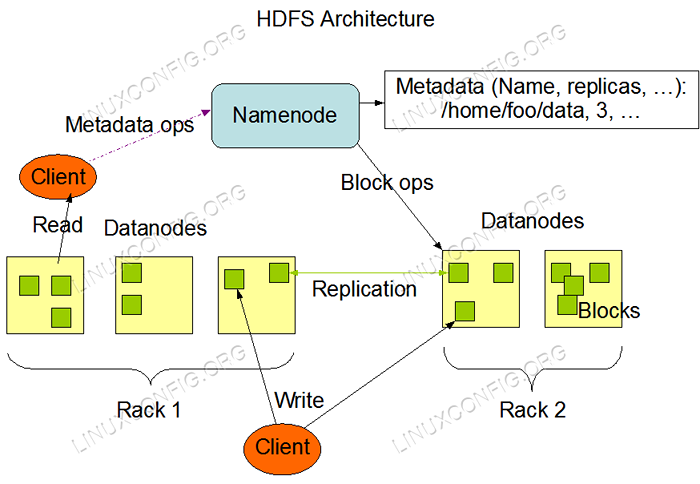

HDFS Architecture.

HDFS Architecture. Keperluan perisian dan konvensyen yang digunakan

| Kategori | Keperluan, konvensyen atau versi perisian yang digunakan |

|---|---|

| Sistem | RHEL 8 / CENTOS 8 |

| Perisian | Hadoop 2.8.5, Oracle JDK 1.8 |

| Yang lain | Akses istimewa ke sistem linux anda sebagai akar atau melalui sudo perintah. |

| Konvensyen | # - Memerlukan arahan Linux yang diberikan untuk dilaksanakan dengan keistimewaan akar sama ada secara langsung sebagai pengguna root atau dengan menggunakan sudo perintah$ - Memerlukan arahan Linux yang diberikan sebagai pengguna yang tidak layak |

Tambahkan Pengguna untuk Persekitaran Hadoop

Buat pengguna dan kumpulan baru menggunakan arahan:

# UserAdd Hadoop # Passwd Hadoop

[root@hadoop ~]# useradd Hadoop [root@hadoop ~]# passwd hadoop menukar kata laluan untuk pengguna hadoop. Kata Laluan Baru: Retype Kata Laluan Baru: Passwd: Semua Token Pengesahan Dikemas kini dengan jayanya. [root@hadoop ~]# kucing /etc /passwd | Grep Hadoop Hadoop: X: 1000: 1000 ::/rumah/Hadoop:/bin/bash

Pasang dan konfigurasikan Oracle JDK

Muat turun dan pasang JDK-8U202-LINUX-X64.Pakej Rasmi RPM untuk memasang Oracle JDK.

[root@hadoop ~]# rpm -ivh jdk-8u202-linux-x64.Amaran RPM: JDK-8U202-LINUX-X64.RPM: Header V3 RSA/SHA256 Tandatangan, ID Utama EC551F03: NoKey Verifying ... ####################################################################################################################araan 100%] Menyediakan ... ############################# [100%] Mengemas kini / memasang ... 1: jdk1.8-2000: 1.8.0_202-FCS ############################# [100%] Membongkar fail balang ... alat.Jar ... plugin.Jar ... Javaws.JAR ... Deploy.Jar ... Rt.Jar ... Jsse.Jar ... charsets.Jar ... Localedata.balang ..

Selepas pemasangan untuk mengesahkan Java telah berjaya dikonfigurasikan, jalankan arahan berikut:

[root@hadoop ~]# java -versi versi java "1.8.0_202 "Java (TM) SE Runtime Environment (Membina 1.8.0_202-B08) Java Hotspot (TM) 64-bit Server VM (Bina 25.202-b08, mod campuran) [root@hadoop ~]# update-alternatives-config java ada 1 program yang menyediakan 'java'. Perintah Pemilihan ----------------------------------------------- * + 1/usr/java/jdk1.8.0_202-amd64/jre/bin/java

Konfigurasikan ssh tanpa kata laluan

Pasang pelayan SSH terbuka dan buka klien SSH atau jika sudah dipasang maka ia akan menyenaraikan pakej di bawah.

[root@hadoop ~]# rpm -qa | Grep Openssh* Openssh-Server-7.8p1-3.EL8.x86_64 OpenSSL-LIBS-1.1.1-6.EL8.x86_64 OpenSSL-1.1.1-6.EL8.x86_64 OpenSsh-Clients-7.8p1-3.EL8.x86_64 OpenSSH-7.8p1-3.EL8.x86_64 OpenSSL-PKCS11-0.4.8-2.EL8.x86_64

Menjana pasangan utama awam dan swasta dengan arahan berikut. Terminal akan meminta memasukkan nama fail. Tekan Masukkan dan teruskan. Setelah itu menyalin borang kunci awam id_rsa.pub ke diberi kuasa_keys.

$ ssh -keygen -t rsa $ Cat ~/.SSH/ID_RSA.pub >> ~/.SSH/Authorized_keys $ chmod 640 ~/.SSH/Authorized_keys

[Hadoop@Hadoop ~] $ ssh -keygen -t RSA Menjana pasangan kunci RSA awam/swasta. Masukkan fail di mana untuk menyimpan kunci (/rumah/hadoop/.ssh/id_rsa): direktori '/rumah/hadoop/.ssh '. Masukkan frasa laluan (kosong tanpa frasa laluan): Masukkan frasa laluan yang sama sekali lagi: pengenalan anda telah disimpan di/rumah/hadoop/.SSH/ID_RSA. Kunci awam anda telah diselamatkan di/rumah/hadoop/.SSH/ID_RSA.pub. Cap jari utama ialah: SHA256: H+LLPKAJJDD7B0F0JE/NFJRP5/FUEJSWMMZPJFXOELG [email protected] pasir.com imej rawak kunci adalah: +--- [RSA 2048] ---- +| ... ++*o .O | | o… +.O.+o.+| | +... * +oo == | | . o o . E .OO | | . = .S.* o | | . o.O = O | | ... o | | .o. | | o+. | + ---- [SHA256] -----+ [Hadoop@Hadoop ~] $ Cat ~/.SSH/ID_RSA.pub >> ~/.SSH/Authorized_keys [Hadoop@Hadoop ~] $ chmod 640 ~/.SSH/Authorized_keys

Sahkan konfigurasi SSH yang kurang kata laluan dengan arahan:

$ ssh

[Hadoop@Hadoop ~] $ SSH Hadoop.Kotak pasir.Com Web Console: https: // Hadoop.Kotak pasir.com: 9090/atau https: // 192.168.1.108: 9090/ Masuk Terakhir: Sat 13 Apr 12:09:55 2019 [Hadoop@Hadoop ~] $

Pasang Hadoop dan konfigurasikan fail XML yang berkaitan

Muat turun dan ekstrak Hadoop 2.8.5 dari laman web rasmi Apache.

# wget https: // arkib.Apache.Org/Dist/Hadoop/Common/Hadoop-2.8.5/Hadoop-2.8.5.tar.GZ # TAR -XZVF HADOOP -2.8.5.tar.Gz

[root@rhel8-sandbox ~]# wget https: // arkib.Apache.Org/Dist/Hadoop/Common/Hadoop-2.8.5/Hadoop-2.8.5.tar.GZ --2019-04-13 11: 14: 03-- https: // arkib.Apache.Org/Dist/Hadoop/Common/Hadoop-2.8.5/Hadoop-2.8.5.tar.GZ Menyelesaikan Arkib.Apache.org (arkib.Apache.org) ... 163.172.17.199 Menyambung ke Arkib.Apache.org (arkib.Apache.org) | 163.172.17.199 |: 443 ... bersambung. Permintaan HTTP Dihantar, Menunggu Respons ... 200 OK Panjang: 246543928 (235m) [Aplikasi/X-GZIP] Penjimatan ke: 'Hadoop-2.8.5.tar.Gz 'Hadoop-2.8.5.tar.GZ 100%[================================================= ====================================>] 235.12m 1.47MB/s dalam 2m 53S 2019-04-13 11:16:57 (1.36 MB/s) - 'Hadoop -2.8.5.tar.GZ 'disimpan [246543928/246543928]

Menyediakan pembolehubah persekitaran

Edit Bashrc Bagi pengguna Hadoop melalui menyediakan pembolehubah persekitaran Hadoop berikut:

Eksport HADOOP_HOME =/rumah/Hadoop/Hadoop-2.8.5 eksport hadoop_install = $ Hadoop_Home Export Hadoop_Mapred_Home = $ Hadoop_Home Export Hadoop_Common_Home = $ Hadoop_Home Export Hadoop_Hdfs_Home = $ Hadoop_Home Export Yarn_Home Eksport Hadoop_Opts = "-Djava.Perpustakaan.Path = $ hadoop_home/lib/asli " Sumber .Bashrc dalam sesi log masuk semasa.

$ sumber ~/.Bashrc

Edit Hadoop-ENV.sh fail yang ada /etc/Hadoop Di dalam direktori pemasangan Hadoop dan buat perubahan berikut dan periksa jika anda ingin menukar konfigurasi lain.

Eksport java_home = $ java_home:-"/usr/java/jdk1.8.0_202-AMD64 " Eksport HADOOP_CONF_DIR = $ HADOOP_CONF_DIR:-"/Home/Hadoop/Hadoop-2.8.5/etc/Hadoop " Perubahan konfigurasi di tapak teras.Fail XML

Edit tapak teras.XML dengan vim atau anda boleh menggunakan mana -mana editor. Fail tersebut berada di bawah /etc/Hadoop dalam Hadoop direktori rumah dan tambahkan penyertaan berikut.

fs.defaultfs HDFS: // Hadoop.Kotak pasir.com: 9000 Hadoop.TMP.dir /rumah/Hadoop/Hadooptmpdata Di samping itu, buat direktori di bawah Hadoop folder rumah.

$ mkdir hadooptmpdata

Perubahan konfigurasi di tapak HDFS.Fail XML

Edit tapak HDFS.XML yang terdapat di bawah lokasi yang sama i.e /etc/Hadoop dalam Hadoop direktori pemasangan dan buat Namenode/Datanode direktori di bawah Hadoop direktori rumah pengguna.

$ mkdir -p hdfs/namenode $ mkdir -p hdfs/daTanode

DFS.replikasi 1 DFS.nama.dir Fail: /// Home/Hadoop/HDFS/Namenode DFS.data.dir Fail: /// Home/Hadoop/HDFS/Datanode Perubahan Konfigurasi di Laman Mapred.Fail XML

Salin tapak peta.XML dari tapak peta.XML.templat menggunakan cp perintah dan kemudian edit tapak peta.XML diletakkan di /etc/Hadoop di bawah Hadoop Direktori Instillation dengan perubahan berikut.

$ cp mapred-site.XML.Template Mapred-site.XML

MapReduce.Rangka Kerja.nama Benang Perubahan konfigurasi di tapak benang.Fail XML

Edit tapak benang.XML dengan penyertaan berikut.

MapReduceyarn.Nodemanager.Aux-Services mapreduce_shuffle Memulakan kelompok Hadoop

Format namenode sebelum menggunakannya untuk kali pertama. Sebagai pengguna Hadoop menjalankan arahan di bawah untuk memformat namenode.

$ hdfs namenode -format

[Hadoop@Hadoop ~] $ HDFS Namenode -Format 19/04/13 11:54:10 Maklumat Namenode.Namenode: startup_msg: /*********************************************** ***************** startup_msg: Memulakan namenode startup_msg: user = hadoop startup_msg: host = hadoop.Kotak pasir.com/192.168.1.108 startup_msg: args = [-format] startup_msg: versi = 2.8.5 19/04/13 11:54:17 Maklumat Namenode.FSNamesystem: DFS.namenode.safe mode.ambang-pct = 0.9990000128746033 19/04/13 11:54:17 Maklumat Namenode.FSNamesystem: DFS.namenode.safe mode.min.datanodes = 0 19/04/13 11:54:17 Maklumat Namenode.FSNamesystem: DFS.namenode.safe mode.lanjutan = 30000 19/04/13 11:54:18 Metrik maklumat.Topmetrics: nntop conf: dfs.namenode.Atas.tetingkap.num.baldi = 10 19/04/13 11:54:18 Metrik maklumat.Topmetrics: nntop conf: dfs.namenode.Atas.num.Pengguna = 10 19/04/13 11:54:18 Metrik Maklumat.Topmetrics: nntop conf: dfs.namenode.Atas.tingkap.minit = 1,5,25 19/04/13 11:54:18 Maklumat Namenode.FSNamesystem: Cache Cache pada Namenode diaktifkan 19/04/13 11:54:18 Maklumat Namenode.FSNamesystem: Cache Retry akan menggunakan 0.03 Total Heap and Retry Cache Entry Time Time adalah 600000 Millis 19/04/13 11:54:18 Maklumat Util.GSET: Kapasiti Pengkomputeran untuk Peta NamenoderetryCache 19/04/13 11:54:18 Maklumat Util.GSET: jenis VM = 64-bit 19/04/13 11:54:18 Maklumat.GSET: 0.0299999999329447746% Max Memory 966.7 MB = 297.0 kb 19/04/13 11:54:18 Maklumat Util.GSet: Kapasiti = 2^15 = 32768 Penyertaan 19/04/13 11:54:18 Maklumat Namenode.FSImage: Blockpoolid baru yang diperuntukkan: BP-415167234-192.168.1.108-1555142058167 19/04/13 11:54:18 Maklumat biasa.Penyimpanan: Direktori Penyimpanan/Rumah/Hadoop/HDFS/Namenode telah berjaya diformat. 19/04/13 11:54:18 Maklumat Namenode.FSImageFormatProtobuf: Menyimpan Fail Imej/Laman Utama/Hadoop/HDFS/Namenode/Current/FSImage.CKPT_000000000000000000000 Menggunakan No Mampatan 19/04/13 11:54:18 Maklumat Namenode.FSImageFormatProtobuf: Fail Imej/Laman Utama/Hadoop/HDFS/Namenode/Current/FSImage.CKPT_000000000000000000000 saiz 323 bait disimpan dalam 0 saat. 19/04/13 11:54:18 Maklumat Namenode.NnstorageretentionManager: akan mengekalkan 1 imej dengan txid> = 0 19/04/13 11:54:18 Maklumat Util.Exitutil: Keluar dengan Status 0 19/04/13 11:54:18 Maklumat Namenode.Namenode: shutdown_msg: /*********************************************** *************** Shutdown_msg: Menutup Namenode di Hadoop.Kotak pasir.com/192.168.1.108 ******************************************************* *************/

Setelah namenode telah diformat maka mulakan HDF menggunakan start-dfs.sh Skrip.

$ start-dfs.sh

[Hadoop@Hadoop ~] $ start-dfs.SH Memulakan Namenodes di [Hadoop.Kotak pasir.com] Hadoop.Kotak pasir.com: Memulakan namenode, pembalakan ke/rumah/hadoop/hadoop-2.8.5/Log/Hadoop-Hadoop-Namenode-Hadoop.Kotak pasir.com.keluar Hadoop.Kotak pasir.com: Memulakan Datanode, Logging ke/Home/Hadoop/Hadoop-2.8.5/Log/Hadoop-Hadoop-Datanode-Hadoop.Kotak pasir.com.keluar bermula namenode sekunder [0.0.0.0] Keaslian tuan rumah '0.0.0.0 (0.0.0.0) 'Tidak dapat ditubuhkan. Cap jari kunci ECDSA ialah sha256: e+nfcek/kvnignwdhgfvikhjbwwwghiijjkfjygr7nki. Adakah anda pasti mahu terus menyambung (ya/tidak)? Ya 0.0.0.0: Amaran: Tambah secara kekal '0.0.0.0 '(ECDSA) ke senarai tuan rumah yang diketahui. [email protected] Laluan 0: 0.0.0.0: Memulakan Secondarynamenode, Logging to/Home/Hadoop/Hadoop-2.8.5/Log/Hadoop-Hadoop-Secondarynamenode-Hadoop.Kotak pasir.com.keluar

Untuk memulakan perkhidmatan benang, anda perlu melaksanakan skrip permulaan benang i.e. Start-Yarn.sh

$ start-yarn.sh

[Hadoop@Hadoop ~] $ Start-Yarn.SH Memulakan Benang Daemon Memulakan ResourceManager, Pembalakan ke/Home/Hadoop/Hadoop-2.8.5/log/benang-hadoop-resourcemanager-hadoop.Kotak pasir.com.keluar Hadoop.Kotak pasir.com: Memulakan Nodemanager, Logging to/Home/Hadoop/Hadoop-2.8.5/log/benang-hadoop-nodemanager-hadoop.Kotak pasir.com.keluar

Untuk mengesahkan semua perkhidmatan Hadoop/daemon dimulakan dengan jayanya, anda boleh menggunakan JPS perintah.

$ JPS 2033 Namenode 2340 Secondarynamenode 2566 ResourceManager 2983 JPS 2139 Datanode 2671 NodeManager

Sekarang kita boleh menyemak versi Hadoop semasa yang boleh anda gunakan di bawah arahan:

versi $ Hadoop

atau

$ HDFS versi

[Hadoop@Hadoop ~] $ Hadoop versi Hadoop 2.8.5 subversi https: // git-wip-us.Apache.org/repos/ASF/Hadoop.Git -R 0B8464D75227FCEE2C6E7F2410377B3D53D3D5F8 disusun oleh JDU pada 2018-09-10T03: 32Z disusun dengan protok 2.5.0 Dari Sumber dengan Checksum 9942CA5C745417C14E318835F420733 Perintah ini dijalankan menggunakan/Home/Hadoop/Hadoop-2.8.5/Share/Hadoop/Common/Hadoop-Common-2.8.5.JAR [Hadoop@Hadoop ~] $ HDFS versi Hadoop 2.8.5 subversi https: // git-wip-us.Apache.org/repos/ASF/Hadoop.Git -R 0B8464D75227FCEE2C6E7F2410377B3D53D3D5F8 disusun oleh JDU pada 2018-09-10T03: 32Z disusun dengan protok 2.5.0 Dari Sumber dengan Checksum 9942CA5C745417C14E318835F420733 Perintah ini dijalankan menggunakan/Home/Hadoop/Hadoop-2.8.5/Share/Hadoop/Common/Hadoop-Common-2.8.5.Jar [Hadoop@Hadoop ~] $

Antara muka baris arahan HDFS

Untuk mengakses HDFS dan buat beberapa direktori atas DFS anda boleh menggunakan HDFS CLI.

$ hdfs dfs -mkdir /testdata $ hdfs dfs -mkdir /hadoopdata $ hdfs dfs -ls /

[Hadoop@Hadoop ~] $ HDFS DFS -LS / FOUND 2 ITEM DRWXR-XR-X-Hadoop Supergroup 0 2019-04-13 11:58 / Hadoopdata DRWXR-XR-X-Hadoop Supergroup 0 2019-04-13 11: 59 /TestData

Akses namenode dan benang dari penyemak imbas

Anda boleh mengakses kedua -dua UI Web untuk Namenode dan Pengurus Sumber Benang melalui mana -mana pelayar seperti Google Chrome/Mozilla Firefox.

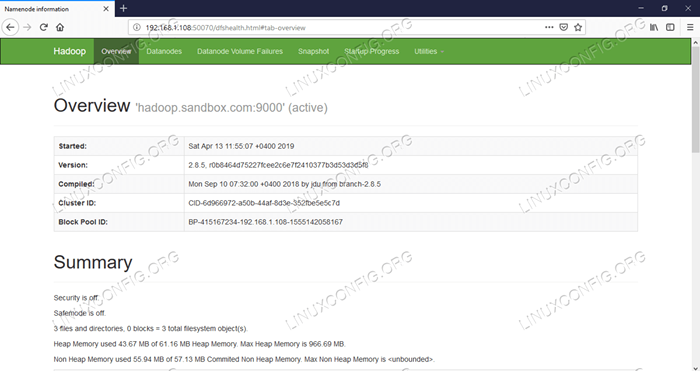

Namenode Web UI - http: //: 50070

Antara muka pengguna web namenode.

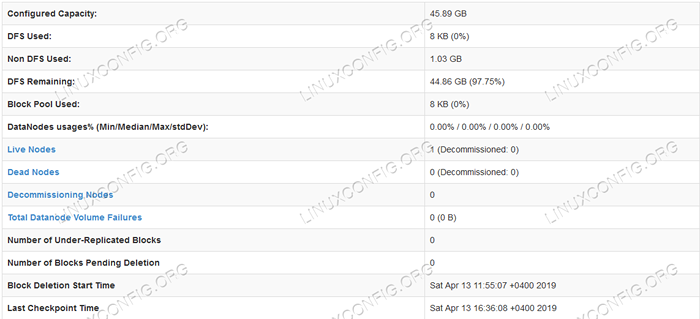

Antara muka pengguna web namenode.  Maklumat terperinci HDFS.

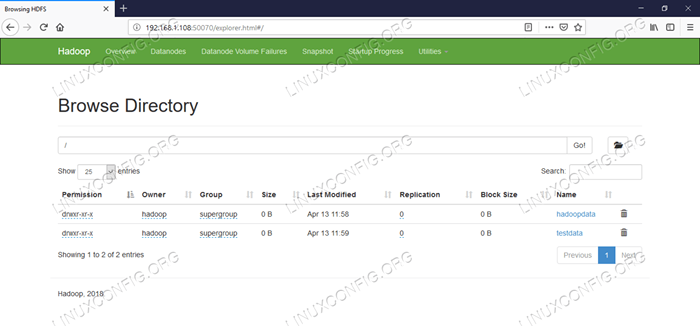

Maklumat terperinci HDFS.  Layari Direktori HDFS.

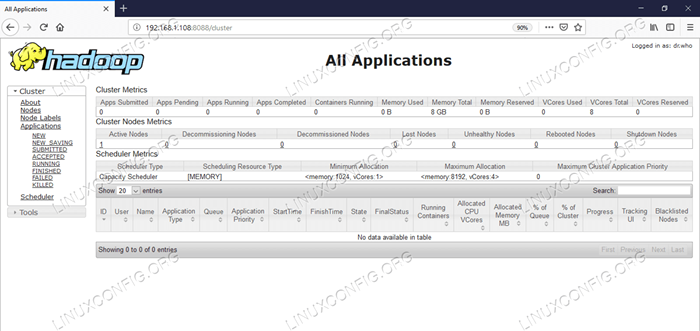

Layari Direktori HDFS. Antara muka web Pengurus Sumber Benang (RM) akan memaparkan semua pekerjaan yang sedang berjalan pada cluster Hadoop semasa.

UI Web Pengurus Sumber - http: //: 8088

Antara Muka Pengguna Web Sumber (Benang).

Antara Muka Pengguna Web Sumber (Benang). Kesimpulan

Dunia mengubah cara ia beroperasi pada masa ini dan data besar memainkan peranan utama dalam fasa ini. Hadoop adalah rangka kerja yang memudahkan kita semasa bekerja pada set data yang besar. Terdapat peningkatan di semua bidang. Masa depan menarik.

Tutorial Linux Berkaitan:

- Ubuntu 20.04 Hadoop

- Perkara yang hendak dipasang di Ubuntu 20.04

- Cara Membuat Kluster Kubernet

- Cara memasang kubernet di ubuntu 20.04 Focal Fossa Linux

- Cara memasang Kubernet di Ubuntu 22.04 Jur -ubur Jammy ..

- Perkara yang perlu dilakukan setelah memasang ubuntu 20.04 Focal Fossa Linux

- Perkara yang perlu dipasang di Ubuntu 22.04

- Cara Bekerja Dengan API Rest WooCommerce dengan Python

- Cara Mengurus Kluster Kubernet dengan Kubectl

- Pengenalan kepada Automasi, Alat dan Teknik Linux

- « Cara memasang wordpress.aplikasi desktop com di Ubuntu 19.04 Disco Dingo Linux

- Cara Memasang Redmine Pada Rhel 8 / CentOS 8 Linux »