Cara Memasang Apache Kafka di Debian 11/10

- 4139

- 446

- Daryl Wilderman

Apache Kafka adalah platform streaming yang diedarkan. Ia berguna untuk membina saluran paip data streaming masa nyata untuk mendapatkan data antara sistem atau aplikasi. Ciri lain yang berguna adalah aplikasi streaming masa nyata yang dapat mengubah aliran data atau bertindak balas pada aliran data.

Tutorial ini akan membantu anda memasang Apache Kafka di Debian 11, Debian 10, dan Debian 9 Linux Systems.

Langkah 1 - Pasang Java

Apache Kafka memerlukan java untuk dijalankan. Anda mesti memasang Java pada sistem anda. Jalankan arahan di bawah untuk memasang OpenJDK lalai pada sistem anda dari PPA rasmi.

sudo apt kemas kini sudo apt memasang lalai-jdk

Langkah 2 - Muat turun Apache Kafka

Muat turun fail binari Apache Kafka dari laman web muat turun rasmi. Anda juga boleh memilih cermin yang berdekatan untuk dimuat turun.

wget https: // dlcdn.Apache.org/kafka/3.2.0/Kafka_2.13-3.2.0.TGZ Kemudian ekstrak fail arkib

tar xzf kafka_2.13-3.2.0.TGZsudo mv kafka_2.13-3.2.0/usr/local/kafka

Langkah 3 - Buat fail unit Systemd

Seterusnya, buat fail unit systemd untuk perkhidmatan zookeeper dan kafka. Ini akan membantu menguruskan perkhidmatan Kafka untuk memulakan/berhenti menggunakan arahan SystemCtl.

Pertama, buat fail unit Systemd untuk Zookeeper dengan arahan di bawah:

VIM/etc/Systemd/System/Zookeeper.perkhidmatan

Tambahkan kandungan di bawah:

[Unit] Keterangan = Apache Zookeeper Server Documentation = http: // zookeeper.Apache.org memerlukan = rangkaian.Sasaran jauh-FS.sasaran selepas = rangkaian.Sasaran jauh-FS.sasaran [perkhidmatan] jenis = mudah execstart =/usr/local/kafka/bin/zookeeper-server-start.sh/usr/local/kafka/config/zookeeper.Properties execstop =/usr/local/kafka/bin/zookeeper-server-stop.sh restart = on-abnormal [Install] Wanteby = Multi-User.sasaran

Simpan fail dan tutupnya.

Seterusnya, untuk membuat fail unit sistemd Kafka menggunakan arahan berikut:

Vim/etc/Systemd/System/Kafka.perkhidmatan

Tambahkan kandungan di bawah. Pastikan untuk menetapkan yang betul Java_home jalan mengikut java yang dipasang pada sistem anda.

[Unit] Description = Apache Kafka Server Documentation = http: // kafka.Apache.org/dokumentasi.html memerlukan = zookeeper.perkhidmatan [perkhidmatan] jenis = persekitaran mudah = "java_home =/usr/lib/jvm/java-1.11.0-opengdk-amd64 "execstart =/usr/local/kafka/bin/kafka-server-start.sh/usr/local/kafka/config/pelayan.sifat execstop =/usr/local/kafka/bin/kafka-server-stop.SH [Pasang] Wanteby = Multi-User.sasaran

Simpan fail dan tutup.

Muat semula daemon Systemd untuk menggunakan perubahan baru.

Systemctl Daemon-Reload

Langkah 4 - Mula pelayan Kafka

Kafka Diperlukan Zookeeper Jadi Pertama, Mulakan Pelayan Zookeeper pada Sistem Anda. Anda boleh menggunakan skrip yang tersedia dengan Kafka untuk memulakan contoh Zookeeper tunggal.

SUDO Systemctl Mula Zookeeper

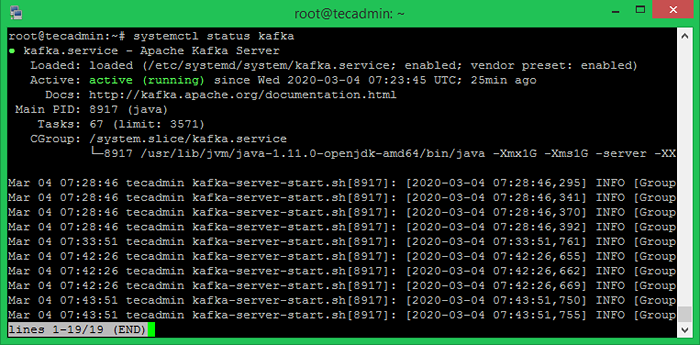

Sekarang mulakan pelayan Kafka dan lihat status berjalan:

SUDO Systemctl Mula Kafka Sudo Systemctl Status Kafka

Semua selesai. Pemasangan Kafka telah berjaya diselesaikan. Bahagian tutorial ini akan membantu anda bekerja dengan pelayan Kafka.

Langkah 5 - Buat topik di Kafka

Kafka menyediakan skrip shell yang banyak dibina untuk mengusahakannya. Pertama, buat topik bernama "testtopic" dengan partition tunggal dengan replika tunggal:

CD/USR/Local/Kafka Bin/Kafka-Topics.sh --create-bootstrap-server localhost: 9092 --Replication-Factor 1-Partitions 1-Testtopic Testtopic Topic Testtopic.

Faktor replikasi menerangkan berapa banyak salinan data yang akan dibuat. Seperti yang kita jalankan dengan satu contoh, simpan nilai ini 1.

Tetapkan pilihan partition sebagai bilangan broker yang anda mahukan data anda dibahagikan antara. Seperti yang kita jalankan dengan satu broker, menyimpan nilai ini 1.

Anda boleh membuat pelbagai topik dengan menjalankan arahan yang sama seperti di atas. Selepas itu, anda dapat melihat topik yang dibuat di Kafka dengan arahan di bawah:

Bin/Kafka-Topics.sh -list --zookeeper localhost: 9092 testtopic tecadmintutorial1 tecadmintutorial2

Sebagai alternatif, bukannya membuat topik secara manual, anda juga boleh mengkonfigurasi broker anda untuk membuat topik auto apabila topik yang tidak wujud diterbitkan ke.

Langkah 6 - Hantar mesej ke Kafka

"Pengeluar" adalah proses yang bertanggungjawab untuk memasukkan data ke Kafka kami. Kafka dilengkapi dengan pelanggan baris arahan yang akan mengambil input dari fail atau dari input standard dan hantar sebagai mesej ke kluster Kafka. Kafka lalai menghantar setiap baris sebagai mesej berasingan.

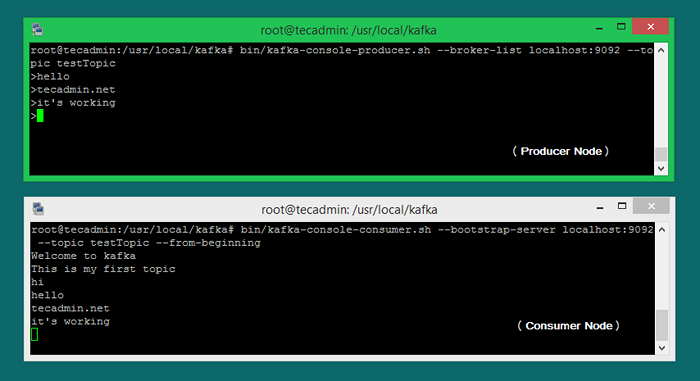

Mari jalankan pengeluar dan kemudian taipkan beberapa mesej ke dalam konsol untuk dihantar ke pelayan.

Bin/Kafka-Console-Producer.SH --Broker-List Localhost: 9092-Testtopic Topik> Selamat Datang ke Kafka> Ini Topik Pertama Saya>

Anda boleh keluar dari arahan ini atau memastikan terminal ini berjalan untuk ujian selanjutnya. Sekarang buka terminal baru ke proses pengguna Kafka pada langkah seterusnya.

Langkah 7 - Menggunakan Pengguna Kafka

Kafka juga mempunyai pengguna baris arahan untuk membaca data dari kluster Kafka dan memaparkan mesej ke output standard.

Bin/Kafka-Console-Consumer.SH --Bootstrap-Server Localhost: 9092-Testtopic Topic-dari-Beginning Selamat Datang ke Kafka Ini adalah topik pertama saya

Sekarang, jika anda masih menjalankan pengeluar kafka (langkah #6) di terminal lain. Taipkan beberapa teks pada terminal pengeluar itu. ia akan dapat dilihat dengan segera di terminal pengguna. Lihat tangkapan skrin di bawah pengeluar dan pengguna Kafka dalam bekerja:

Kesimpulan

Anda telah berjaya memasang dan mengkonfigurasi perkhidmatan Kafka pada sistem Debian Linux.

- « Cara Mengkonfigurasi X-Frame-Options di Apache

- Cara memeriksa alamat IP di Ubuntu 20.04 (desktop) »